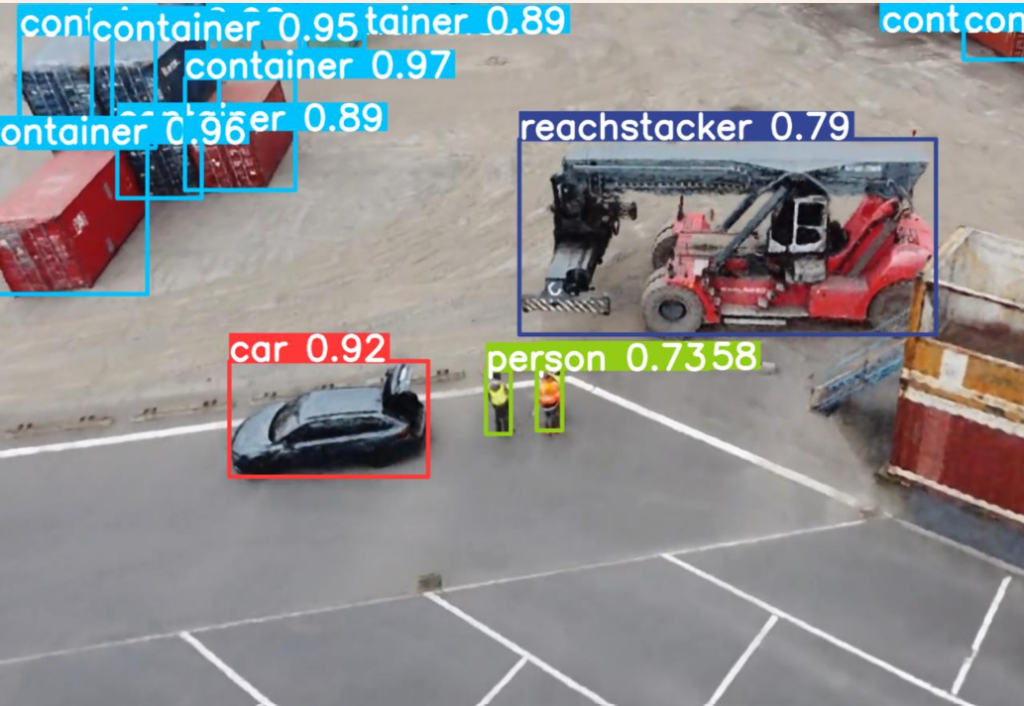

Objekterkennung aus Drohnenperspektive

Im Mittelpunkt von InteGreatDrones steht die automatisierte, visuelle Identifikation von Ladungsträgern zur Digitalisierung von Hafenprozessen mittels Drohneneinsatz. Dafür ist die Objekterkennung aus UAV-Perspektive eine Grundvoraussetzung. Erst die Erkennung der Transporteinheiten ermöglicht die spätere Zuordnung zu ihrer ID-Nummer und schließlich deren Identifikation. Die Erkennung von Transporteinheiten und deren Lokalisierung in Bildern ist aufgrund der UAV-Perspektive sowie der spezifischen Hafenumgebung derzeit nicht kommerziell verfügbar und ein offenes Forschungsfeld. Mit Hilfe entsprechender Aufnahmen aus Drohnenflügen trainieren und entwickeln wir eigene, robuste KI-Modelle und Algorithmen für den Anwendungsfall.

Digitalisierung durch Fahrzeugsensorik

Ergänzend zur Überwachung mit Drohnen und fester Infrastruktur werden Daten im Terminal mit Hilfe von Sensorik an Fahrzeugen erfasst. Dazu entwickeln wir eine Sensorbox, welche mit verschiedenen Sensoren ausgestattet ist. GPS-Module zur präzisen Standortbestimmung, Abstandssensoren zur Überwachung des Beladungszustands und Kameras, ermöglichen eine umfassende Abbildung des Terminalumfeldes. Die erhobenen Daten werden in Echtzeit auf einem Edge-Gerät vorverarbeitet und anschließend in Systeme des Hafenbetreibers integriert.

Digitaler Zwilling zur Prozessunterstützung

Der digitale Zwilling stellt die Hafenumgebung, Stellplätze und Lagerflächen schematisch dar. Er bildet die aktuelle Belegung der Stellfächen mit Ladungsträgern wie Containern und Trailern visuell ab. Die interaktive Oberfläche und ergänzende Listendarstellungen erlauben es Nutzern Informationen wie ID, Position und Bestimmungsort schnell zu erhalten. Um eine stets aktuelle Datenbasis zu gewährleisten, wird der digitale Zwilling mit Daten diverser Sensorsysteme gespeist und eine entsprechende Ansicht für das operative Personal ermöglicht das Nachpflegen und Korrigieren von Informationen.

Bilderkennungsmodelle

In Häfen weltweit wird die Bilderkennungstechnologie zunehmend als unverzichtbares Instrument zur Steigerung der Sicherheit und Effizienz eingesetzt. Durch die Analyse visueller Daten in Echtzeit ermöglichen Bilderkennungsmodelle eine präzise Überwachung von Frachtbewegungen und die frühzeitige Erkennung verdächtiger Aktivitäten. Maschinelles Lernen und künstliche Intelligenz ermöglichen eine automatisierte Reaktion auf potenzielle Risiken, was die Reaktionszeiten drastisch verkürzt und menschliche Fehler minimiert. Diese Technologie trägt nicht nur zur Sicherheit bei, sondern optimiert auch die Betriebsabläufe, indem sie die Effizienz der Hafenlogistik verbessert. In einer Zeit des zunehmenden Handelsvolumens und der komplexen Sicherheitsbedrohungen stellt die Integration von Bilderkennungstechnologien einen bedeutenden Fortschritt für Häfen dar, um den Herausforderungen des 21. Jahrhunderts gerecht zu werden.

Simulation und synthetische Daten

Unsere KI Modelle benötigen große Mengen an Bildern als Trainingsdaten. Wir ergänzen daher Bilder aus der realen Welt durch synthetische Bilddaten aus einer Unity Umgebung. Der dort entwickelte digitale Zwilling soll eine hochdetaillierte digitale Kopie der Binnenterminalumgebung von Dresden bzw. Riesa darstellen. Damit lassen sich neue und schwer generierbare Daten wie Witterungseffekte auf Containern und Videomaterial in bestimmten Wind-, Wetter und Tagesbedingungen erstellen. Zusätzlich ermöglicht die Umgebung uns ohne großen Resourceneinsatz Drohnenflüge zu simulieren, um optimale Routen und Kamerawinkel für Überflüge zu bestimmen.

Erfassung von Nummernschildern

InteGreatDrones befasst sich neben Containern auch mit Lkw-Anhängern bzw. kranbaren Trailern. Für deren Identifizierung stellen Nummernschilder eine wichtige Informationsquelle dar. Mithilfe der Objektdetektion seltener Klassen kann der relevante Bereich hochauflösender Kamerabilder extrahiert werden, der das Nummernschild enthält. Mithilfe einer Segmentierungsmaske kann die Ausrichtung des Schildes berechnet werden, sodass es mithilfe eines Scherprozesses begradigt werden kann. Schließlich bestimmen wir mit Hilfe von OCR (Optical Character Recognition) die Buchstaben und Ziffern, Dies hilft zu verstehen, welche Fahrzeuge und Trailer sich derzeit im Terminal befinden und ist so essentiell für Prozessüberwachung und Sicherheit.